Dein Video mit Text ist nur einen Prompt entfernt! Mit SORA ist das jetzt wirklich sehr einfach möglich.

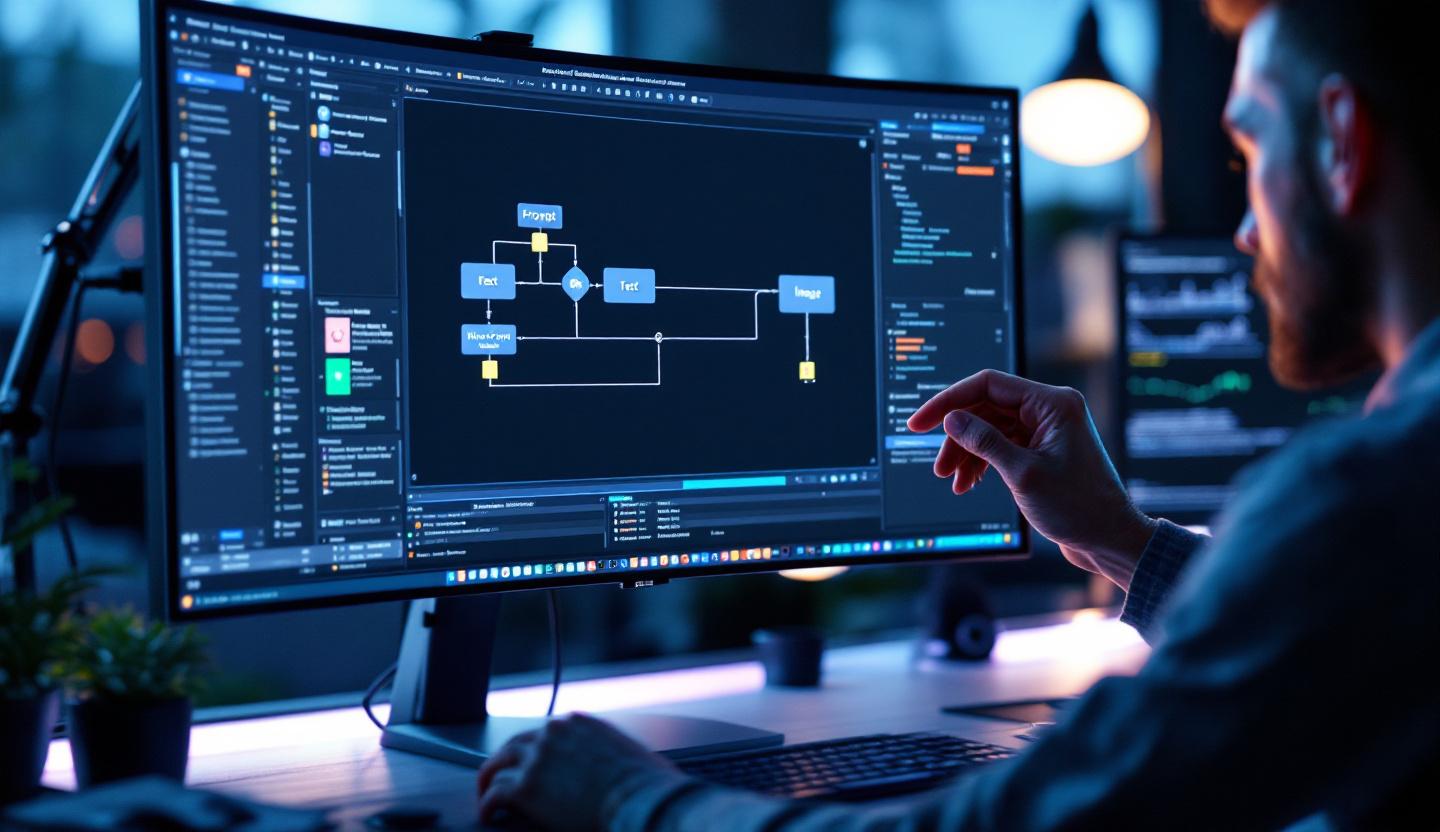

In wenigen Minuten liegt ein fertiges KI-generiertes Video vor. Genau das liefert ein gut aufgebauter make.com-Workflow mit dem SORA-Modell. Das Video dazu gibt es auf YouTube.

Das Grundprinzip: Szenarien modular denken

Bevor wir hier richtig einsteigen, muss ich eine Lanze für das Thema „Subszenarien“ brechen! Mit dieser Funktion von make.com kannst du deine Szenarien ganz einfach wiederverwenden.

Du kapselst Funktionalität in Unter-Szenarien (wie Unterprogramme). Jedes Szenario beginnt mit „Start a Scenario“, definiert Inputs und Outputs und liefert am Ende eine Ergebnis-URL. So baust du eine AI-Toolbox aus Einzeltools, die du je nach Bedarf kombinierst. Das macht deine Lösung robust, testbar und wiederverwendbar.

Drei Workflow-Varianten kurz erklärt

In unserem Beispiel haben wir drei unterschiedliche Wege zur Generierung des Videos getestet. Jede Option nutzt dieselbe Grundstruktur, unterscheidet sich aber in der Eingabe:

- Prompt → Video: Du gibst direkt den Videoprompt an. Das Hauptszenario prüft Parameter wie Videoprompt, Video-Modell, Format, Größe und Länge. Beim Start werden diese Parameter an das Modell übergeben. Nach kurzer Wartezeit bekommst du die Video-URL.

- Text → Prompt → Video: Ein Text (z. B. Blogpost) wird analysiert. Subjekt, Umfeld, Stimmung und weitere Merkmale werden extrahiert und in einen englischsprachigen Videoprompt überführt. Dieser Prompt wandert in die gleichen Variablen wie bei Variante 1 und läuft weiter wie gewohnt.

- Bild → Video: Du übergibst eine Bild-URL und einen Videoprompt. Achte darauf, dass die Bildauflösung zum Zielvideo passt, damit keine Verzerrung entsteht. Das Bild dient als Referenz. Am Ende erhältst du wieder eine statische Cloud-URL.

Easy, oder?

So setzt du das „Parent-Szenario“ in make.com auf

Das sind die wichtigsten Schritte, die du umsetzt, damit der Workflow stabil läuft:

- Definiere Eingabeparameter: videoprompt, text_vor_video_prompt, ignore_text_option, video_model (SORA2 | SORA2 Pro), format, size, length.

- Erstelle ein Prüfmodul, das feststellt, ob der direkte Prompt oder der aus Text generierte Prompt genutzt wird.

- Nutze eine HTTP- oder API-Client-Action, um das SORA-Endpoint aufzurufen und die Parameter zu übergeben.

- Implementiere ein Modul zur Speicherung: Lade das Ergebnis in die Cloud (z. B. Google Drive, S3 oder ein CDN) und speichere die statische URL.

- Füge Fehlerbehandlung und Retry-Logik hinzu. Setze Timeouts und prüfe das Modell-Response-Format.

- Logge Metadaten wie Prompt-Varianten, Modellversion und Dateigröße für spätere Analyse.

SORA 2 ist einfach genial. Aber was wähle ich aus?

SORA 2 bietet Grundfunktionen. SORA 2 Pro unterstützt zusätzliche Formate ohne manuelle Anpassung. Bei SORA 2 musst du Format- oder Größenanpassungen vorab vornehmen. Leg bspw. die Videolänge explizit fest. Halte Prompt-Variablen konsistent, damit Unter-Szenarien sie zuverlässig übernehmen.

Achte auf die Sprache des Prompts. Viele Modelle liefern bessere Ergebnisse mit englischsprachigen Prompts. Wenn du aus deutschem Text einen Prompt erzeugst, übersetze oder formatiere die Extraktion so, dass Subjekt, Stimmung und Action klar benannt sind.

Los geht’s!