ElevenLabs kennst du wahrscheinlich von den herausragenden Text-to-Voice Voice Funktionalitäten.

Jetzt überrascht es mit einer Funktion, die weit darüber hinausgeht: Musik per API!

Was bisher spezialisierten Tools wie Suno vorbehalten war, ist jetzt auch direkt mit ElevenLabs möglich und das automatisiert und in bestehende Workflows integrierbar. Besonders spannend wird es, wenn Musik nicht isoliert entsteht, sondern nahtlos in Content-Prozesse eingebunden wird: vom Blogartikel bis zum Podcast.

Was dieses Tutorial abdeckt

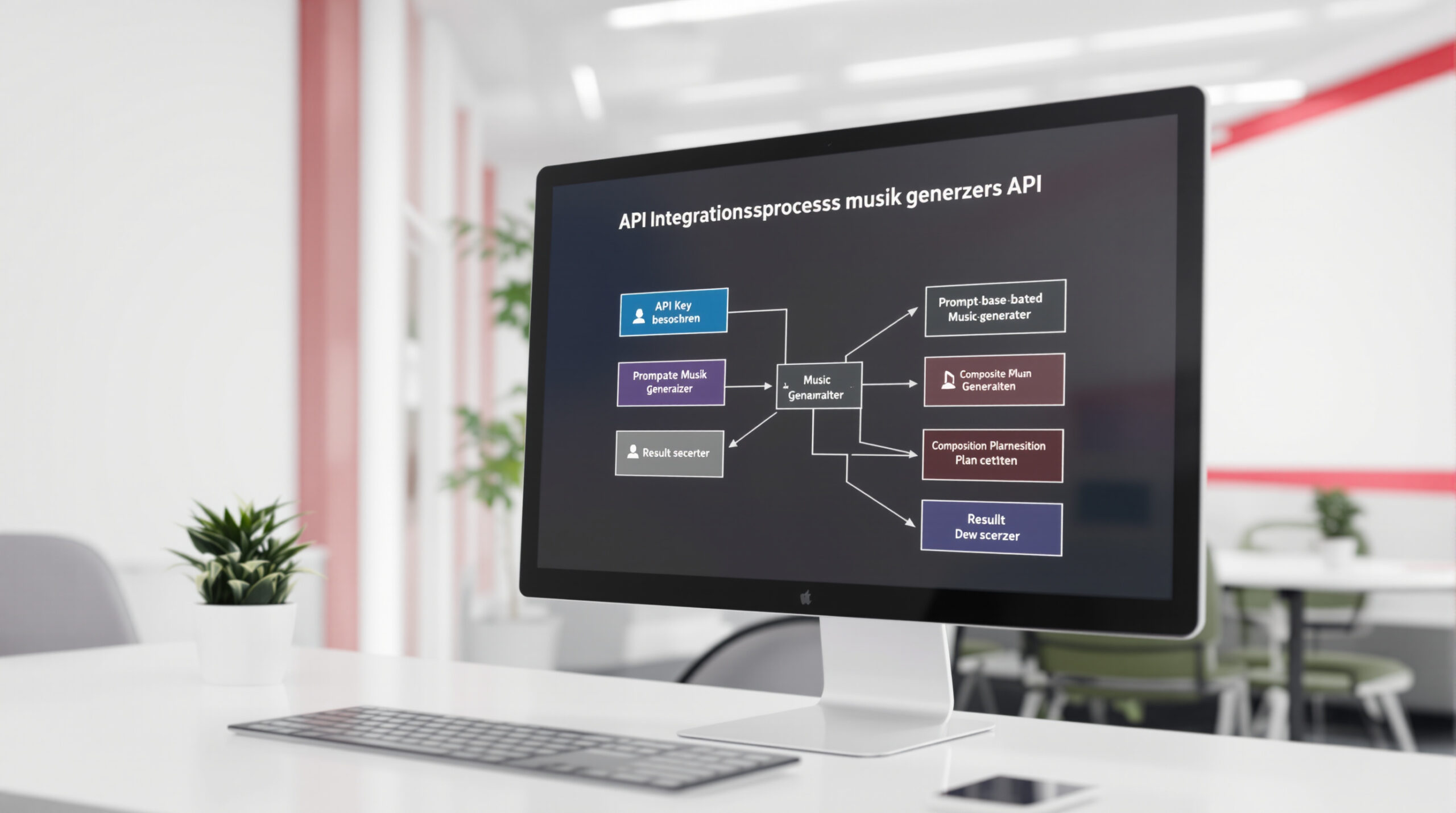

Du bekommst eine klare Anleitung, wie du Eleven Labs Music über die API in ein Make-Szenario einbindest. Ich erkläre beide Wege der Musikgenerierung: einfachen Prompt-basierten Aufruf und detaillierte „Kompositionspläne“. Du wirst verstehen, welche Daten du sendest, wie du die Antwort weiterverarbeitest und wie sich beide Methoden klanglich unterscheiden.

Voraussetzungen

Du brauchst ein Eleven Labs-Konto mit API-Zugang und einen aktiven Make-Account. Zusätzliche Module wie Google Drive oder HTTP-Calls erleichtern das Ablegen und Weiterverarbeiten der generierten Dateien.

Wenn du das noch nicht hast, nutze gerne unsere Affiliate-Links zum Sign-Up:

Kurzübersicht: Zwei Generierungswege

Die beiden Ansätze kurz erklärt:

- Prompt-basierte Generierung: Du gibst einen freien Prompt (z. B. „modern driving electronic“) und eine Länge an. Das funktioniert schnell und direkt.

- Composition Plan (Compose Music with Details): Du erzeugst ein JSON-basiertes Dokument mit globalen Stilen und Sections (Intro, Vers, Refrain etc.). Damit steuerst du Struktur und Stil präziser. (hier bin ich direkt hellhörig geworden!)

Schritt-für-Schritt: Integration in Make

Kostenloser Blueprint zur KI-Musik-Generierung mit make.com und Elevenlabs

Ich beschreibe hier im Detail den typischen Ablauf zur Musikgenerierung in Make. Du kannst ihn 1:1 übernehmen und sogar (um noch schneller zu sein) direkt unseren Blueprint herunterladen und direkt loslegen!

1) API-Key besorgen und Verbindung herstellen

Die komplette Dokumentation der API findest du hier. Aber keine Sorge, wir leiten dich schrittweise durch!

Melde dich bei Eleven Labs an und öffne den Bereich Developers > API Keys. Kopier deinen API-Key. In Make fügst du das Eleven Labs-Modul hinzu. Da es noch kein spezielles Modul für die Musik-Funktion gibt ist, nutze das Modul make An API Call für direkte API-Aufrufe von Elevenlabs.

2) Prompt-basierte Musik generieren

Stell in Make einen HTTP-Call zusammen mit diesen Parametern:

- Endpoint: V1 Music (POST): /v1/music

- Content-Type: application/json

- Body: JSON mit Prompt-Text und length (in Millisekunden)

{

„prompt“: „{{12.musicPrompt}}“,

„music_length_ms“: {{12.musicLength}}

}

Die API liefert einen Binary-Buffer mit Audiodaten zurück. In Make kannst du diese Binärdaten direkt weiterverarbeiten, zum Beispiel ins Google Drive hochladen oder an einen Videogenerator schicken.

3) Composition Plan erzeugen und verwenden

Anstatt nur einen Prosa-Prompt zu senden, kannst du auch eine ganze Komposition erstellen!

Dafür rufst du zunächst den Endpoint Create composition plan mit /v1/music/plan auf. Die API gibt dir ein JSON-Dokument zurück, das den Composition Plan enthält. Typische Felder sind:

- positive_global_styles: z. B. „Modern Electronic Driving“

- negative_global_styles: z. B. „Metal, Country“

- sections: Array mit Intro, Aufbau, Refrain, Ende und deren Längen

Anschließend tranfsormierst du das in ein JSON und rufst mit diesem Ergebnis den Endpunkt für „Compose Music with Details“ (/v1/music/detailed) auf. Ergebnis: ein völlig anderes, oft strukturierteres Stück als bei reinem Prompt! Du hast deutlich mehr Kontrolle.

Auch diese Komposition kannst du dann beispielsweise auf GDrive hochladen.

Praktische Hinweise und Tipps für KI Musik

Halte Prompt und Länge als Variablen im Szenario. So kannst du automatisiert verschiedene Längen und Stile erzeugen. Bei kurzen Proben / Intros reichen bspw. 10.000 ms (10 s), ansonsten kannst du auch ganze Lieder generieren. Begrenze API-Keys nach Möglichkeit, wenn du sie teilst (Rechte eingrenzen).

Zu den zwei Erstellungsmethoden:

Die Prompt-Methode liefert schnell ein brauchbares Resultat. Sie eignet sich für Prototypen und Kurzformate. Composition Plans geben dir Kontrolle über Struktur und Stil. Du erreichst damit gezielte Ergebnisse für Podcasts, Videos oder wiederkehrende Content-Formate.

Integration in deine Workflows

Du kannst diese Musik-API mit anderen Automatisierungen koppeln, zum Beispiel bei deinen Avatar-Videos für Instagram Reels oder für abwechslungsreiche Podcast-Intros. So entsteht ein Prozess, der bei Content-Publishing automatisch passendes Audio erstellt und ablegt.

Das war’s von unserer Seite… Viel Erfolg beim Automatisieren deiner Musikproduktion!

Das komplette Video zu KI Musik mit Eleven Labs

Die komplette Anleitung zum Nachbauen: Das komplette Video von Sven findest auf YouTube!